Inhaltsverzeichnis

Spracherkennung klingt nach Zukunft, ist aber längst Alltag. Du sprichst, ein System hört zu, und am Ende steht Text. Genau das ist die Kernidee: Ein Computer soll gesprochene Sprache so verstehen, dass daraus eine verlässliche schriftliche Version entsteht. Im Business ist das besonders spannend, weil Sprache in Meetings, Calls und Interviews ständig entsteht, aber selten sauber dokumentiert wird.

Wichtig ist eine kurze Abgrenzung: Spracherkennung beantwortet die Frage „Was wurde gesagt?“. Sprechererkennung beantwortet: „Wer hat gesprochen?“. In der Praxis taucht beides zusammen auf, aber es sind unterschiedliche Aufgaben.

In diesem Artikel bekommst du einen verständlichen, aber trotzdem fundierten Überblick. Du lernst, wie Spracherkennung technisch funktioniert, wie sich die Verfahren historisch entwickelt haben, welche klassischen und modernen Ansätze es gibt und wo die Grenzen liegen. Am Ende schauen wir kurz darauf, wie Tools wie Sally AI Spracherkennung heute im Meeting-Alltag nutzen.

Geschichtlicher Abriss der Spracherkennung

Die ersten Spracherkennungssysteme entstanden schon in den 1960er Jahren. Damals war das Ziel noch sehr begrenzt: einzelne Wörter oder kleine Wortlisten erkennen, meistens unter Laborbedingungen.

Später kam ein entscheidender Schritt: Man begann, Sprache statistisch zu modellieren. Ab den 1980er Jahren wurden Sprachmodelle populär, die aus großen Textmengen lernten, welche Wortfolgen typischerweise zusammen auftreten. Das half enorm, ähnliche oder gleich klingende Wörter im Kontext zu unterscheiden.

In den 1990er Jahren wurden Diktierprogramme im Büro bekannter, weil PCs schneller wurden. Trotzdem war die Nutzung oft mühsam: Training, Korrekturen, begrenzte Robustheit.

Der große Sprung passierte ab den 2010er Jahren mit Deep Learning. Neuronale Netze konnten Muster in Audiosignalen deutlich besser lernen als die älteren Verfahren. Seitdem ist Spracherkennung so gut geworden, dass sie in Smartphones, Videocalls und Unternehmenssoftware selbstverständlich ist.

Grundlagen der Spracherkennung

Damit ein System Sprache in Text umwandeln kann, braucht es mehrere Schritte. Du kannst dir das wie eine Kette vorstellen, in der jedes Glied eine klare Aufgabe hat.

Zuerst wird Audio aufgenommen. Das ist ein kontinuierliches Signal, also eine Welle, die sich über die Zeit verändert. Damit ein Computer damit arbeiten kann, wird das Signal in sehr kurze Abschnitte zerlegt, oft nur wenige Millisekunden lang.

Dann passiert die Merkmalsextraktion. Statt die Rohwelle direkt zu nutzen, berechnet man aus jedem kurzen Abschnitt Merkmale, die für Sprache typisch sind. Diese Merkmale beschreiben grob, wie die Energie über Frequenzen verteilt ist. Das klingt technisch, ist aber im Kern einfach: Das System will erkennbare Muster, die zu Lauten passen.

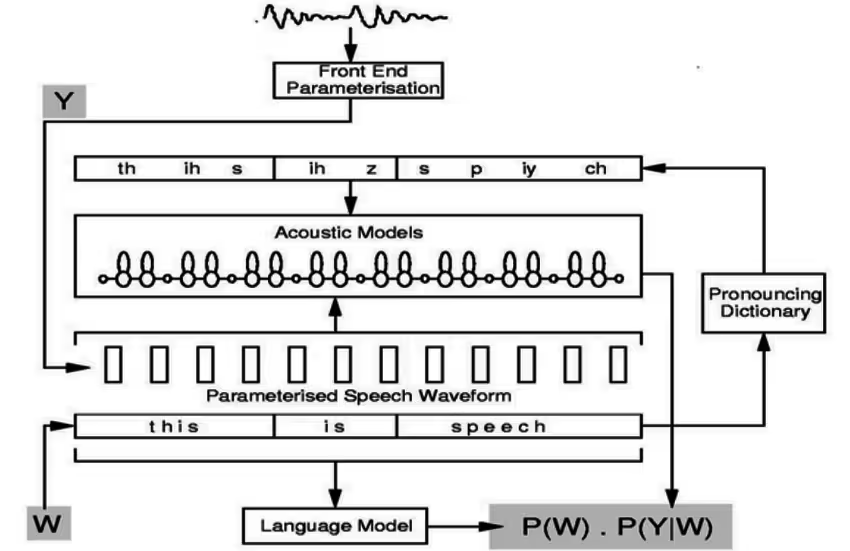

In klassischen Systemen sind danach drei Bausteine zentral:

- Akustisches Modell: Es schätzt, welche Laute oder Lautteile gerade wahrscheinlich sind.

- Lexikon (Aussprache-Wörterbuch): Es weiß, wie Wörter typischerweise ausgesprochen werden und wie Laute zu Wörtern zusammenpassen.

- Sprachmodell: Es bewertet, welche Wortfolge im Kontext am plausibelsten ist.

Am Ende entscheidet ein Decoder, welche Wortfolge insgesamt am besten passt, also welche Erklärung für das Audio die höchste Wahrscheinlichkeit hat.

Ein simples Beispiel: Das Audio kann so klingen, dass sowohl „Wetter“ als auch „Vetter“ möglich wären. Das Sprachmodell hilft dann, weil „wie wird das Wetter“ in normalen Sätzen viel häufiger vorkommt als „wie wird das Vetter“.

Klassische Verfahren: HMM und N-Gramme

Wenn du Spracherkennung der letzten Jahrzehnte verstehen willst, musst du zwei Begriffe kennen: Hidden-Markov-Modelle (HMM) und N-Gramm-Sprachmodelle.

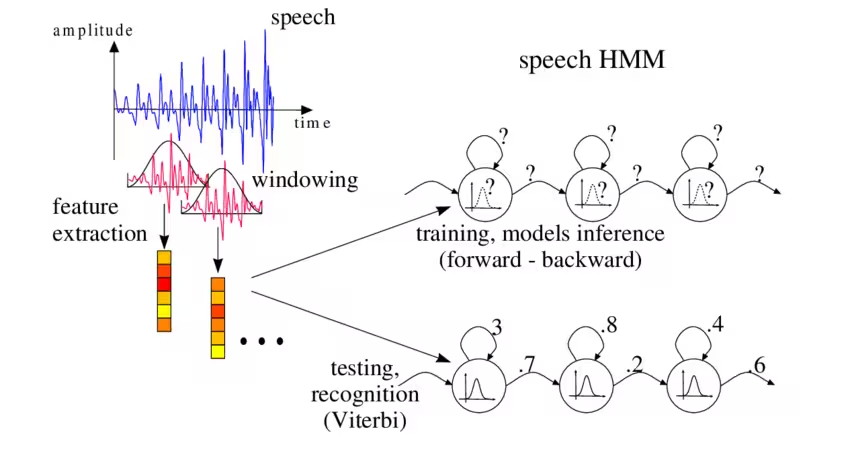

Warum HMMs so gut passen

Sprache ist ein Zeitprozess. Laute kommen nacheinander, und die genaue Dauer eines Lauts ist variabel. HMMs sind genau dafür gebaut: Sie modellieren Zustände, die sich über die Zeit entwickeln, und sie können Unsicherheit abbilden.

In einem klassischen Spracherkenner repräsentieren die „versteckten Zustände“ grob sprachliche Einheiten, zum Beispiel Phoneme oder Teile davon. Das System beobachtet nicht direkt den Zustand, sondern nur das Audiosignal. Es schätzt dann, welche Zustandsfolge am wahrscheinlichsten zum beobachteten Audio passt.

Früher wurden dabei oft Gaussian Mixture Models (GMM) genutzt, um zu beschreiben, wie Merkmale für einen Laut aussehen. Später wurden diese akustischen Teile häufig durch neuronale Netze ersetzt, aber das HMM-Prinzip blieb zunächst gleich.

N-Gramme als Sprachmodell

Ein N-Gramm-Modell ist eine statistische Methode, die aus Textdaten lernt, wie wahrscheinlich eine Wortfolge ist. „N“ bedeutet, wie viele Wörter Kontext betrachtet werden.

- Ein Bi-Gramm schaut auf das vorherige Wort.

- Ein Tri-Gramm schaut auf die zwei vorherigen Wörter.

Das ist extrem praktisch, weil es ein typisches Problem löst: Viele Wörter klingen ähnlich. Mit Kontext wird die Entscheidung leichter.

Die Schwäche ist aber ebenfalls klar: N-Gramme sehen nur einen kurzen Kontext. Komplexe Bedeutungszusammenhänge über einen ganzen Satz oder Absatz hinweg erfassen sie kaum. Trotzdem waren HMM plus N-Gramm über viele Jahre der Standard, weil das System gut erklärbar war, relativ stabil funktionierte und sich gezielt optimieren ließ.

Moderne Verfahren: Deep Learning und End-to-End-Systeme

Mit Deep Learning hat sich die Spracherkennung grundsätzlich verändert. Statt viele Einzelteile einzeln zu bauen und zu trainieren, lässt man große neuronale Netze Muster direkt aus Daten lernen.

DNN-HMM, der hybride Übergang

Ein wichtiger Zwischenschritt waren hybride Systeme. Hier blieb das HMM als zeitliches Gerüst erhalten, aber das akustische Modell wurde durch ein tiefes neuronales Netz ersetzt. Diese DNN-HMM-Systeme wurden schnell deutlich besser, weil neuronale Netze komplexe Muster im Audiosignal robuster erkennen können.

Das war ein pragmatischer Vorteil: Man konnte bewährte HMM-Decoding-Methoden behalten und trotzdem von Deep Learning profitieren.

End-to-End: Audio direkt zu Text

Heute sind End-to-End-Modelle in vielen Szenarien führend. End-to-End bedeutet: Ein Modell lernt, Audio direkt in Text zu übersetzen, ohne dass du zwingend getrennte Module wie Lexikon und klassisches Sprachmodell brauchst.

Typische End-to-End-Ansätze sind:

- CTC-basierte Modelle: Sie lernen eine Ausrichtung zwischen Audioschritten und Textsymbolen.

- Attention-basierte Encoder-Decoder-Modelle: Sie lernen, welche Teile des Audios für welches Textstück relevant sind.

- RNN-Transducer (RNN-T): Sie sind besonders für Streaming geeignet, also wenn Text während des Sprechens erscheinen soll.

- Transformer-Modelle: Sie haben sich in vielen Sprachaufgaben durchgesetzt, auch in ASR.

Ein großer Vorteil moderner Modelle ist die Flexibilität bei Wörtern. Viele Systeme arbeiten mit Subwords oder Zeichen. Das hilft bei Namen, Fachbegriffen oder neuen Begriffen, weil das Modell nicht nur ein starres Wörterbuch braucht.

In der Praxis sieht man oft Mischformen: End-to-End-Modelle werden mit zusätzlichen Sprachmodellen kombiniert, oder hybride Modelle werden im zweiten Schritt durch neuronale „Rescoring“-Techniken verbessert. Das zeigt: Es gibt nicht nur einen Weg, sondern viele gute Engineering-Varianten.

Technologische Herausforderungen und Grenzen

Auch wenn Spracherkennung heute beeindruckend gut ist, bleibt sie fehleranfällig, wenn die Bedingungen schwierig werden. Die wichtigsten Gründe sind oft sehr bodenständig und logisch. Grund dafür ist grundlegend, dass Sprache hochvariabel ist und sich jedes menschliche Stimmsignal unterscheider: Dialekte, Sprechgeschwindigkeiten, Emotionen, Hintergrundgeräusche und soweiter. Genauer aufgeschlüsselt lassen sich grob folgende Gründe definieren:

Audioqualität

Wenn das Mikro schlecht ist, der Raum hallt oder mehrere Personen durcheinander reden, verschlechtert sich die Erkennung. Hintergrundgeräusche, gleichzeitig Sprechen und Distanz zum Mikro sind typische Problemquellen. Für eine möglichst gute Spracherkennung sollte man das also vermeiden. Das heißt: am Besten in einem stillen Raum, mit gutem Mikro (das auch nah genug ist) und ein geordnetes Gespräch. Dann wird die Spracherkennung auch in der Regel sehr gut.

Variabilität von Sprache

Menschen sprechen unterschiedlich. Akzente, Dialekte, Tempo, Emotionen und individuelle Aussprache machen das Problem schwer. Das ist kein Bug, sondern die Natur von Sprache. Man sollte also darauf achten, dass im Lexikon (siehe Grundlagen der Spracherkennung oben) auch der entsprechend gesprochene Dialekt vorhanden ist. Wie zum Beispiel Schweizer-Deutsch, Bayrisch oder Berlinerisch.

Fachbegriffe, Eigennamen und Zahlen

Jargon, Produktnamen, Abkürzungen und Kundennamen sind besonders kritisch. Hier hilft oft ein angepasstes Vokabular oder domänenspezifisches Training. Hier sollten am Besten Tools gewählt werden, die auch benutzerdefiniertes Vokabular unterstützen.

Satzzeichen und Lesbarkeit

Viele Systeme transkribieren zunächst nur Wortfolgen. Punkt, Komma und Großschreibung müssen extra ergänzt werden, damit das Ergebnis gut lesbar ist. Moderne Systeme haben oft eine KI mitlaufen, die das automatisch macht. Trotzdem gilt: 100% fehlerfreie Ergebnisse sind sehr selten und beim KI-Einsatz nicht zu garantieren (technisch quasi unmöglich). Bei juristischen Diktaten oder medizinischen Befunden ist deswegen eine menschliche Qualitätskontrolle immer noch üblich und auch empfehlenswert.

Datenschutz und Compliance

Zwar kein Herausforderung im Transkript-Kontext, aber trotzdem erwähnenswert: Datenschutz. Im Unternehmenskontext ist nicht nur Genauigkeit wichtig, sondern auch Datenkontrolle. Wenn Audio in der Cloud verarbeitet wird, musst du wissen, wo die Daten liegen, wie sie gespeichert werden und wer Zugriff hat. DSGVO-Konformität spielt bei europäischen Unternehmen eine große Rolle. Technologien zur lokalen Verarbeitung (On-Device-ASR) gewinnen hier an Bedeutung, um ohne Upload in Rechenzentren von Dritten auszukommen. Das geht allerdings häufig auf Kosten der Erkennungsqualität, weil mobile Geräte deutlich weniger Rechenpower haben.

Typische Einsatzgebiete

Spracherkennung ist im heute längst im Alltag angekommen und bietet auch einige Use-Cases, die langsam immer mehr zum Main-Stream werden. Ein paar typische Szenarien:

Sprachassistenz & Automatisierung

Auf Smartphones und smarten Lautsprechern ist Spracheingabe alltäglich – Siri, Google Assistant, Alexa & Co. ermöglichen per Zuruf Informationen abzurufen, Termine zu planen oder Geräte zu steuern. Im Büroalltag lassen sich so z.B. Kalender-Updates, Erinnerungen oder Anfragen an Chatbots bequem per Sprachbefehl erledigen. Auch Freisprecheinrichtungen im Auto nutzen Spracherkennung, um Navigation oder Anrufe sicher per Stimme zu steuern

Callcenter und Kundenservice

Meetings und interne Kommunikation

Diktat & Dokumentation

Sicherheit & Zugangskontrolle

Spracherkennung dient auch als Sprachsteuerung (z.B. von Maschinen) oder – in Kombination mit Sprechererkennung – zur Authentifizierung. Ein bekanntes Beispiel sind Banking-Hotlines, die anhand der Stimme den Anrufer identifizieren ("Stimme als Passwort"). In Smart-Home-Systemen kann man per Stimme Türen öffnen (verknüpft mit Berechtigungen) oder Alarmanlagen steuern. Hier spielen jedoch Sicherheitserwägungen eine große Rolle, da Fehl-Erkennungen kritische Folgen haben könnten.

Typische Systemarchitekturen

Die Systemarchitektur variiert je nach Anwendung, Programm und natürlich Use-Case. Heut ist das Cloud-Prinzip recht häufig. Aber auch andere Systeme werden genutzt.

Es gibt drei häufige Architekturentscheidungen:

- On-Device vs. Cloud

- On-Device bedeutet, die Erkennung läuft direkt auf dem Gerät. Vorteil: mehr Kontrolle über Daten. Nachteil: oft weniger Rechenleistung.

- Cloud bedeutet, Audio wird an einen Dienst geschickt, der transkribiert. Vorteil: starke Modelle, schnelle Updates. Nachteil: du brauchst saubere Datenschutzprozesse.

- Streaming vs. Batch

- Streaming liefert Text während des Sprechens, wichtig für Live-Untertitel.

- Batch transkribiert nachträglich, oft besser für lange Meetings oder Dateien.

- Pipeline vs. End-to-End

- Pipeline ist der klassische Aufbau mit akustischem Modell, Lexikon, Sprachmodell.

- End-to-End ist ein durchgängiges Modell, das Audio direkt zu Text umsetzt.

In der Praxis kombinieren viele Systeme Elemente davon. Entscheidend ist, dass die Architektur zur Nutzung passt.

Moderne Verwendung mit Sally AI

Im modernen Business-Alltag ist Spracherkennung besonders wertvoll, wenn sie nicht nur Text produziert, sondern direkt in Arbeitsergebnisse übersetzt wird. Genau hier setzt Sally AI an.

Sally nutzt Spracherkennung, um Meetings automatisch zu transkribieren. Darauf baut dann KI auf, die aus dem Text Zusammenfassungen erzeugt, wichtige Punkte hervorhebt und Aufgaben erkennt. Der Mehrwert entsteht also in zwei Stufen: Erst wird Sprache zuverlässig in Text verwandelt, dann wird der Text so strukturiert, dass du ihn direkt nutzen kannst.

Typisch ist zum Beispiel:

- Du bekommst nach dem Meeting eine klare Zusammenfassung statt eines langen Mitschnitts.

- Aufgaben und nächste Schritte werden sichtbar, ohne dass jemand manuell Protokoll schreibt.

- Inhalte werden durchsuchbar, du findest Entscheidungen/Besprochenes schneller wieder.

Im Unternehmenskontext ist zusätzlich wichtig, dass solche Tools sauber in Workflows passen, also eine Schnittstelle zum CRM oder Aufgaben-Tools. Sally bietet auch das. Spracherkennung ist dann nicht nur „Transkription“, sondern ein Baustein für weniger Reibung im Alltag.

Fazit: Geschichte, Funktion und Anwendung der Spracherkennung

Spracherkennung ist die Technologie, die gesprochene Sprache in Text umwandelt. Sie hat sich von frühen Experimenten mit kleinen Wortlisten zu hochpräzisen Systemen entwickelt, die in Smartphones, Videocalls und Unternehmenssoftware täglich eingesetzt werden.

Die grobe technische Entwicklung sieht folgendermaßen aus: Erst dominierten klassische Pipelines mit HMMs und N-Gramm-Sprachmodellen, später kamen hybride DNN-HMM-Systeme, und heute prägen End-to-End-Ansätze mit CTC, RNN-T und Transformern viele moderne Lösungen.

Trotzdem ist Spracherkennung kein Zauber. Audioqualität, Akzente, Fachbegriffe und Datenschutz bleiben reale Herausforderungen. Wenn du diese Faktoren beachtest, wird Spracherkennung aber zu einem sehr praktischen Werkzeug, gerade im Unternehmens-Kontext.

Und genau dort zeigt sich der nächste Schritt mit Sally: Sally AI nutzen Spracherkennung nicht nur, um Text zu erzeugen, sondern um Meetings in klare Ergebnisse zu übersetzen. Das ist der Punkt, an dem aus Technologie echte Produktivität wird. Du kannst Sally kostenlos und ohne Zahlungsinformationen testen.

Meeting-Transkription testen!

Erlebe, wie entspannt Meeting-Notizen sein können. Teste Sally 4 Wochen kostenlos - keine Kreditkarte erforderlich.

Jetzt testenOder: Demo-Termin vereinbaren